기본 배틀 모드를 넘어선, LMArena의 숨겨진 보석들을 발굴해 보자!

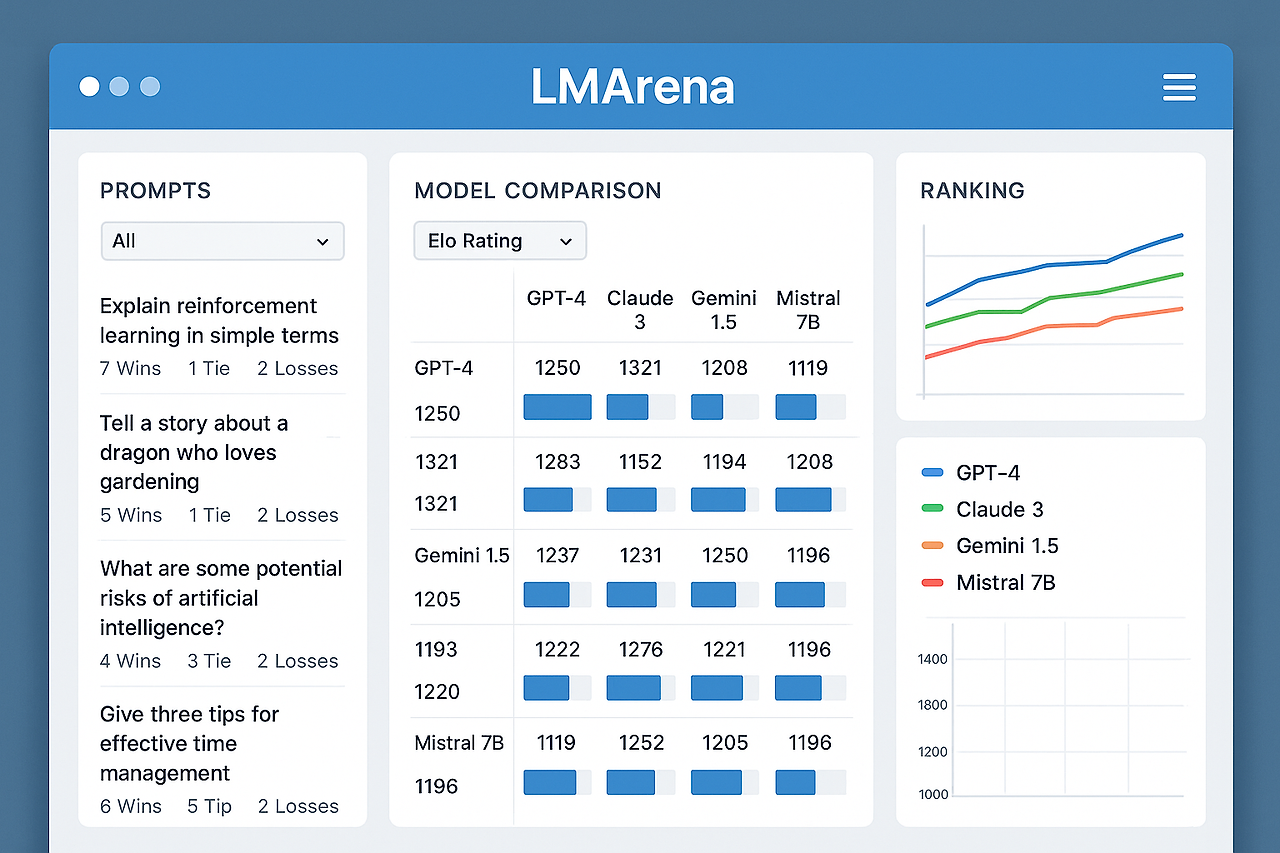

이전 포스팅에서 LMArena의 기본 사용법과 배틀 모드, Elo 시스템에 대해 알아보았는데요. 오늘은 대부분의 사용자들이 놓치고 있는 LMArena의 고급 기능들에 대해 깊이 있게 다뤄보겠습니다. 단순한 AI 모델 비교를 넘어서, 데이터 분석, 커스텀 평가, 전문 연구 도구로서의 진가를 경험해 보세요! 🔍

⚡ Arena Explorer: AI 평가의 새로운 차원

🌟 토픽 모델링으로 보는 사용자 행동 패턴

Arena Explorer는 LMArena가 자랑하는 토픽 모델링 파이프라인입니다. 200만 건 이상의 사용자 프롬프트를 주제별로 분류하여, AI 모델들이 어떤 영역에서 강세를 보이는지 세밀하게 분석할 수 있습니다.

핵심 기술 스택

- BERTopic 프레임워크: 텍스트 임베딩 기반 클러스터링

- OpenAI text-embedding-3-large: 프롬프트 의미 벡터화

- UMAP 차원 축소: 고차원 데이터의 시각화

- HDBSCAN 클러스터링: 계층적 토픽 그룹핑

- GPT-4o 요약: 각 클러스터 특성 자동 분석

📊 실제 데이터로 보는 사용자 트렌드

Arena Explorer를 통해 발견한 흥미로운 패턴들을 살펴보겠습니다.

시간대별 프롬프트 복잡도 변화

- 하드 프롬프트 비율: 2023년 4월 15% → 2025년 8월 28%로 증가

- 코딩 관련 질문: 전체의 18.3%로 가장 높은 비중

- 수학 문제: 학기 중 15% 증가하는 계절성 보임

언어별 상관관계 분석

라틴 계열 언어들 간 높은 상관관계(0.85+), 중국어-일본어 간 0.78의 상관관계를 보이며, 한국어는 다른 언어들과 상대적으로 낮은 상관관계(0.45-0.62)를 나타냅니다.

💡 고급 활용법: 나만의 리서치 인사이트 도출

특정 도메인 모델 성능 분석

# 예시: 창의적 글쓰기 영역에서의 모델 순위

Creative Writing: Claude-3.5-Sonnet (1위) > GPT-4o (2위) > Gemini-Pro (3위)

Code Generation: Cursor-Agent (1위) > GPT-4o (2위) > Claude-3.5-Sonnet (3위)

Math Reasoning: o1-Preview (1위) > GPT-4o (2위) > Gemini-2.0-Flash (3위)

이러한 세분화된 분석을 통해 용도별 최적 모델 선택이 가능합니다.

🎯 Search Arena: 검색 기반 AI의 새로운 평가 기준

🔍 실시간 정보 검색 능력 평가

2025년 3월 출시된 Search Arena는 검색 증강 생성(RAG) 모델들을 전문적으로 평가하는 플랫폼입니다. 단순한 대화형 AI를 넘어 실시간 정보 검색과 종합 분석 능력을 측정합니다.

주요 평가 지표

- 정보 정확성: 검색된 정보의 사실 확인 정도

- 출처 신뢰도: 인용 소스의 품질 및 권위성

- 검색 효율성: 관련성 높은 정보 발견 속도

- 종합 분석력: 다중 소스 정보 통합 능력

📈 Search Arena 데이터 분석

2025년 3월-5월 기간 동안 24,000건의 대화와 12,000건의 투표를 수집하여 13개 모델을 평가했습니다.

주요 발견사항

기술 비교 질문이 15.3%로 가장 높은 비중을 차지하며, 시장분석(12.1%), 엔터테인먼트 캐릭터(11.6%) 순으로 나타났습니다. 이는 사용자들이 Search Arena를 주로 실시간 정보가 중요한 의사결정에 활용하고 있음을 시사합니다.

검색 기반 모델 순위 (2025년 8월 기준)

| 순위 | 모델명 | 특화 영역 |

| 1 | Perplexity-Sonar-Large | 종합 검색 성능 |

| 2 | GPT-4o + Search | 기술 문서 분석 |

| 3 | Claude-3.5 + Search | 학술 논문 요약 |

| 4 | Gemini-2.0-Flash | 실시간 뉴스 분석 |

🎨 커스텀 카테고리 평가 시스템

🏷️ Label Bench: 자동화된 프롬프트 분류 시스템

LMArena의 가장 혁신적인 기능 중 하나는 Label Bench입니다. 이 시스템은 대규모 프롬프트 자동 분류를 통해 세밀한 카테고리별 평가를 가능하게 합니다.

Label Bench 파이프라인

- 1단계: 카테고리 정의 및 체크리스트 작성

- 2단계: 2,000-5,000개 샘플에 대한 Ground Truth 라벨링

- 3단계: 오픈소스 모델(Llama-3.1-70B)로 분류기 훈련

- 4단계: 정확도 96.1%, 정밀도 66.7%, 재현율 96.6% 달성

- 5단계: 전체 200만 개 프롬프트 자동 라벨링

📊 전문 분야별 특화 평가

Creative Writing 카테고리 기준

- 독창성과 상상력이 필요한 프롬프트

- 감정적 또는 예술적 표현 과제

- 고유한 관점이나 해석적 응답 요구

- 단순한 사실 보고를 넘어선 창작 활동

Instruction-Following 정밀 평가

복잡한 다단계 지시사항 수행 능력을 측정하며, 전체 리더보드와 가장 높은 상관관계(0.89)를 보여 범용성 지표로 활용됩니다.

⚒️ 개발자를 위한 고급 도구들

🛠️ Arena-Hard-Auto: 자동화된 벤치마크 생성

Arena-Hard-Auto는 ChatGPT Arena와 가장 높은 상관관계를 보이는 자동 평가 도구입니다.

v2.0 주요 개선사항

- 500개 신선한 도전적 실제 사용자 쿼리: 오픈엔드 소프트웨어 엔지니어링, 수학 문제 등

- 250개 창의적 글쓰기 쿼리: Chatbot Arena에서 직접 수집

- 자동 심사관: GPT-4.1, Gemini-2.5를 통한 빠르고 정확한 평가

- 스타일 제어: 특정 작성 스타일에 대한 평가 지원

📊 PPE (Preference Proxy Evaluations)

PPE는 보상 모델과 LLM 심사관을 평가하기 위한 벤치마크입니다. 실제 인간 선호도 데이터와 검증 가능한 정확성 데이터를 모두 포함합니다.

핵심 평가 지표

- 정확도: 인간이 선호하는 응답 선택률

- 스피어만 상관관계: 20개 모델 순위의 인간 선호도와의 상관성

- 켄달 상관관계: 순위 일치도 측정

- 신뢰도 일치: 95% 신뢰구간 내 순위 일치율

- 분리성: 통계적으로 유의미한 차이를 보이는 순위 비율

🎯 Prompt-to-Leaderboard: 맞춤형 AI 모델 선택

🎪 무한 세분화된 평가 시스템

2025년 2월 출시된 Prompt-to-Leaderboard는 LMArena 활용도를 극적으로 향상한 기능입니다. 특정 프롬프트나 사용 사례에 완벽하게 맞춤화된 리더보드를 생성할 수 있습니다.

작동 원리

사용자가 입력한 프롬프트와 유사한 패턴의 과거 배틀 데이터를 분석하여, 해당 유형의 질문에 가장 뛰어난 성능을 보인 모델들의 순위를 생성합니다.

실제 활용 예시

시나리오: "마케팅 전략 수립을 위한 시장분석 보고서 작성"

커스텀 리더보드 결과:

1. Claude-3.5-Sonnet (분석적 사고 우수)

2. GPT-4o (구조적 보고서 작성 특화)

3. Gemini-Pro (데이터 해석 능력 뛰어남)

4. Llama-3.1-405B (비용 효율적 대안)

라우팅 시스템으로 활용

실험적 라우터(experimental-router-0112)를 통해 각 프롬프트를 최적 모델로 자동 연결하여, 단일 모델보다 우수한 성과를 달성했습니다.

🔬 멀티모달 아레나: 차세대 AI 평가

🎨 비전 아레나의 진화

기존 텍스트 중심 평가를 넘어 이미지, 비디오, 음성 등 다양한 모달리티를 종합 평가하는 시스템입니다.

지원 모달리티

- 비전 분석: 이미지 해석, OCR, 차트 분석

- 비디오 이해: 영상 내용 요약, 장면 분석

- 음성 처리: 음성 인식, 감정 분석

- 복합 태스크: 이미지+텍스트 동시 처리

📱 WebDev Arena: 웹 개발 특화 평가

웹 개발 전문 평가 플랫폼으로, 실제 코드 생성 능력을 정밀 측정합니다.

주요 평가 영역

- 웹사이트 디자인 (15.3%)

- 게임 개발 (12.1%)

- 클론 개발 (11.6%)

- 3D 그래픽스 및 셰이더

- 언어 학습 앱 디자인

모델별 특성 분석

Gemini-2.0-flash는 게임 개발에서 최하위를 기록하지만, 다른 카테고리에서는 상위권 성능을 보여 모델별 특화 영역의 중요성을 입증합니다.

📊 데이터 분석 및 연구 도구

🗄️ 오픈 데이터셋의 보고

LMArena는 AI 연구 커뮤니티를 위한 귀중한 데이터를 지속적으로 공개합니다.

주요 데이터셋

- Arena Human Preference 100K: 10만 건의 인간 선호도 데이터

- Chatbot Arena Conversations: 33,000건의 정제된 대화 데이터

- VisionArena-Chat: 비전 AI 평가 대화

- Search Arena Dataset: 24,000건의 검색 기반 대화

🔍 고급 분석 도구

통계적 신뢰도 검증

- Bradley-Terry 모델: 쌍별 비교 확률 모델링

- 신뢰구간 계산: 95% 신뢰도 기반 순위 검증

- 부트스트래핑: 통계적 유의성 검증

편향 탐지 시스템

투표 조작, 봇 활동, 비정상적 패턴을 자동 탐지하여 평가 신뢰도를 보장합니다.

⚠️ 고급 기능 활용 시 주의사항

🔐 데이터 보안 및 프라이버시

개인정보 보호

- 모든 대화 데이터에서 PII(개인식별정보) 자동 제거

- OpenAI 조절 API를 통한 부적절한 내용 필터링

- 익명화된 사용자 ID로 추적 불가능하게 처리

사용 제한사항

- 일부 고급 기능은 연구용으로 제한

- 대용량 데이터 분석 시 API 호출 제한 존재

- 상업적 이용 시 별도 라이센스 필요

💡 효과적인 활용 전략

단계적 접근법

- 기본 배틀 모드로 전반적 성능 파악

- 카테고리별 리더보드로 특화 영역 분석

- Arena Explorer로 세부 토픽 성능 확인

- 커스텀 리더보드로 맞춤형 모델 선택

연구 프로젝트 설계

- 명확한 연구 질문 설정

- 적절한 샘플 크기 확보 (최소 1,000회 이상 배틀)

- 다양한 평가 지표 병행 사용

- 통계적 유의성 검증 필수

LMArena는 단순한 AI 모델 비교 도구를 넘어서 차세대 AI 연구 플랫폼으로 진화하고 있습니다. 이번 포스팅에서 소개한 고급 기능들을 통해 여러분도 AI 평가 전문가로 한 단계 도약해 보세요!

핵심 성공 포인트

다각도 분석: 단일 지표에 의존하지 말고 여러 기능을 조합하여 활용

지속적 학습: 새로운 기능과 연구 결과를 꾸준히 팔로업

커뮤니티 참여: 연구 결과를 공유하고 피드백을 통한 개선

실용적 적용: 이론적 분석을 실제 업무와 프로젝트에 연결

2025년 하반기에는 더욱 정교한 멀티모달 평가와 실시간 AI 성능 모니터링 기능이 출시될 예정입니다. 지금부터 이러한 고급 기능들에 익숙해져서, AI 기술 발전의 최전선에 서보세요! 🚀

'AI' 카테고리의 다른 글

| 구글 AI 모드 한국어 출시 완벽 가이드 2025: 검색의 새로운 시대를 여는 혁신적 기능 (2) | 2025.09.11 |

|---|---|

| 개발자를 위한 클로드 코드 완벽 활용 가이드 (0) | 2025.09.09 |

| Gemini 숨겨진 고급 기능 완전 정복 2025: 당신이 놓쳤던 혁신적 AI 활용법 (1) | 2025.09.06 |

| 오픈AI '부모 통제 기능' 도입: 챗GPT 안전성 강화의 새로운 전환점 (0) | 2025.09.05 |

| Cursor Agent: AI 코딩의 새로운 혁명 - 개발자를 위한 완벽 가이드 (1) | 2025.09.04 |